website_oloom

-

Oloom

صوت الأم يعزِّز نمو المهارات اللغوية لدى الأطفال الخُدَّج

بقلم هايلي بينيت تشير أول تجربة سريرية مضبوطة عشوائيًّا Randomised-controlled إلى أن تشغيل تسجيلات صوتية للأم قد يساعد في تسريع نضج الدماغ لدى الأطفال الخُدَّج. وقد يسهم هذا التدخّل البسيط في تحسين تنمية المهارات اللغوية لدى الأطفال الذين وُلدوا قبل…

-

الكيمياء

تقنية قديمة تُحْدِث ثورة في الكيمياء الحديثة

بقلم هايلي بينيت تخيل أنك داخل مختبر كيميائي، الأرجح أن ما سيستحضره ذهنك هو صورة نمطية راسخة في المخيلة الشعبية: محاليل تغلي في دوارق كروية القاع، وسوائل تدور في أنابيب اختبار، وقطرات تنساب على مكثفات زجاجية. مشهد كلاسيكي مألوف، لكن…

-

Oloom

الجهاز اللمفاوي .. خط الدفاع الصامت في صون صحتنا

بقلم كاريسا وونغ وضعتُ حجر اليشم البارد الأسطواني الشكل تحت عظم وجنتي، ودحرجته بلطف نحو حافة وجهي. لأكون صادقة، شعرت كأنني قطعة من العجين؛ لكن جدَّتي أكدت لي أن ما أفعله ما هو إلا روتين صيني تقليدي راسخ، من شأنه…

-

البيئة

أحد خزانات الكربون على سطح الأرض يوشك على أن ينهار .. فهل يمكننا إنقاذه؟

بقلم جيمس دينين يحلو لمن ينكرون ظاهرة التغير المناخي التذكير بأن النباتات تزدهر حين ترتفع مستويات ثاني أكسيد الكربون. ومنطقهم يقول إننا كلما أحرقنا مزيدًا من الوقود الأحفوري، ازدادت الأرض خضرةً، وصارت أكثر ملاءمة للحياة عليها، وامتصت كميات أكبر من…

-

البيئة

هل دخل مناخ الأرض مرحلة «صدمة الإنهاء»؟

بقلم مادلين كَاف تخيّل أن السنة هي 2050، وأن العالم توصّل أخيرًا إلى طريقة لوقف الاحترار العالمي. لا، ليس عبر العمل الشاق المتمثّل في خفض انبعاثات الغازات الدفيئة، بل من خلال رشّ جسيمات عاكسة في طبقة الستراتوسفير لتقليل ضوء الشمس…

-

Oloom

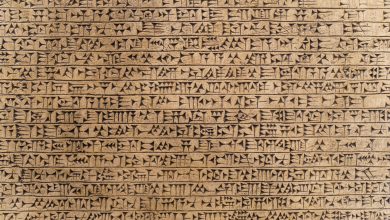

الصفر .. الرقم الأهم في الرياضيات كلها بدأ بداية متواضعة

بقلم جيكوب آرون ما الرقم الأهم في الرياضيات كلها؟ قد يبدو هذا سؤالًا ساذجًا؛ فكيف يمكن اختيار رقم واحد من بين عدد لا نهائي من الاحتمالات؟ ربما يكون للرقمين 2 أو 10 حظ أوفر في نيل هذا اللقب، مقارنة برقم…

-

Oloom

الفوضى الخلّاقة في الدماغ تحدث تحولًا في فهمنا الذكاء والوعي والإبداع

بقلم ديفيد روبسون تأمّل يومَك، وفكّر في كل المهام المذهلة التي ساعدك دماغك على إنجازها؛ من تنظيف أسنانك، إلى تناول الغداء، وقراءة الكلمات على هذه الصفحة، تجد أن أفكارك ومشاعرك وتصرفاتك تبدو كأنها ناتجة عن آلة ضُبطت على نحو دقيق.…

-

Oloom

الالتهاب المزمن يعبث بأدمغتنا، فما يسعنا أن نفعل للتخفيف من وطأته؟

بقلم مانويلا كالاري منذ أن بدأ يعي العالمَ من حوله، كان غلام خاندكر Golam Khandaker شاهدًا على آلام والدته من جراء التهاب المفاصل، إلى جانب معاناتها الاكتئاب. وقد لاحظ خاندكر التزامن الدقيق بين نوبات التهاب المفاصل الحادة لديها وتفاقم حالتها…

-

Oloom

حرب البيانات المسمومة: كيف يواجه صانعو المحتوى جشع الذكاء الاصطناعي؟

بقلم كريس ستوكل-ووكر ولَّت الأيام التي كانت فيها الإنترنت فضاء يغلب عليه حضور البشر، ينشرون تحديثاتهم على وسائل التواصل الاجتماعي، أو يتبادلون الصور الساخرة؛ ففي النصف الأول من 2025، ولأول مرة منذ بدء تتبع البيانات، لم يعد البشر هم من…

-

Oloom

نهاية اللانهاية .. ثورة رياضية على الأعداد الهائلة

بقلم كاميلا بادفيك-كالاغان كم عدد الذرات في الكون المرصود؟ تشير التقديرات الحالية إلى عدد يُكتب على هيئة 1 يتبعه 80 صفرًا، أي 8010. وإذا نظرنا داخل كل ذرة وعددنا الجسيمات دون الذرية فيها؛ فقد نتمكن من العد إلى رقم أعلى…